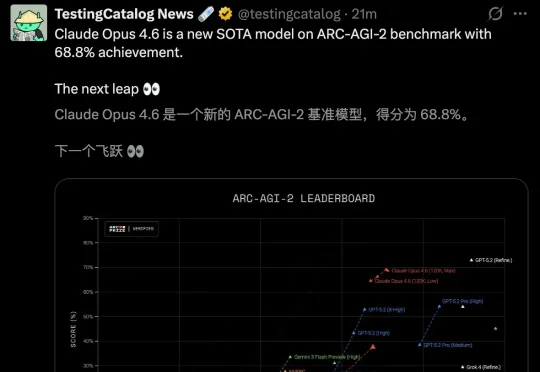

Claude新模型4.6来了!更多饭碗没了:华尔街财务、编译器、安全白帽、PPT…通通失守

Claude新模型4.6来了!更多饭碗没了:华尔街财务、编译器、安全白帽、PPT…通通失守一睁眼,Anthropic上新模型,让Claude Opus 4.6来给您拜!年!了!

一睁眼,Anthropic上新模型,让Claude Opus 4.6来给您拜!年!了!

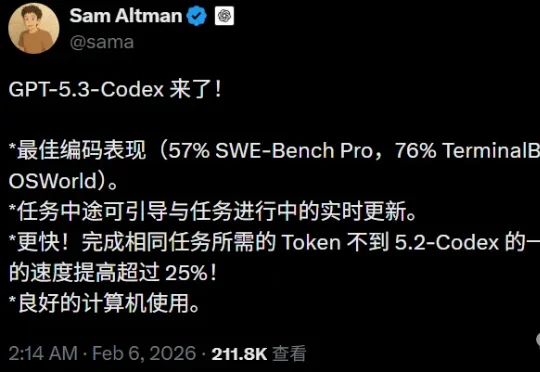

一天之内,两大编程AI轮番轰炸硅谷。Claude Opus 4.6之后,奥特曼紧急放出GPT-5.3-Codex。双雄争霸,彻底撕开AI王座争夺战的帷幕。

整个硅谷又癫狂了!Anthropic深夜扔出王炸,Claude 4.6用近乎恐怖的编程能力和智能体军团,给OpenAI和谷歌上了一堂名为「降维打击」的课。

为什么在LLM推理能力大幅跃升的2026,我们依然只有AI Copilot而没有AI Teammate?尽管AI编程工具遍地开花,但不管是Claude Code还是Codex,本质上仍是“单Agent开发”或“主从控制”架构。而“AI结对编程”迟迟无法落地?

关注我比较久的朋友可能都知道,我用 AI 有个习惯。

家人们,大瓜! 国外有位叫 Richard Weiss 的开发者花了 70 美元,把 Claude 4.5 Opus 给——审!讯!了!而且审出了 Claude 的人生观、世界观、价值观,足足 1.4 万 token。

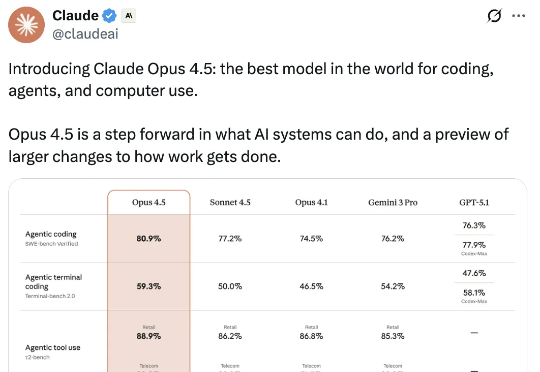

刚刚,Claude Opus 4.5问世,主打编码、Agent与computer use。Opus 4.5在前端开发、视觉能力上显著提升,更擅长使用电脑。在深度研究、PPT制作与电子表格处理等日常任务方面的表现也全面升级。

游戏理解领域模型LynkSoul VLM v1,在游戏场景中表现显著超过了包括GPT-4o、Claude 4 Sonnet、Gemini 2.5 Flash等一众顶尖闭源模型。背后厂商逗逗AI,亦在现场吸引了不少关注的目光。

核心速递: GLM-4.6 发布,榜单排名提升,价格不变 实测效果对齐 Claude 4,超越其他国产模型 GLM 开发者包月套餐升级,1/7 价格取得 Claude 4 9/10 的效果,值得使用

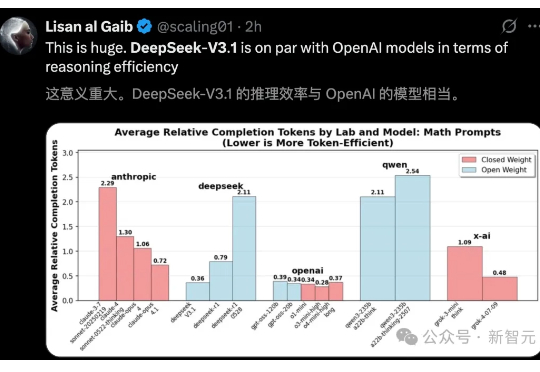

DeepSeek-V3.1官宣了,作为首款「混合推理」模型,将开启智能体新时代。新模型共有671B参数,编码实力碾压DeepSeek-R1、Claude 4 Opus,登顶编程开源第一。